こんにちは、ぺぐです!

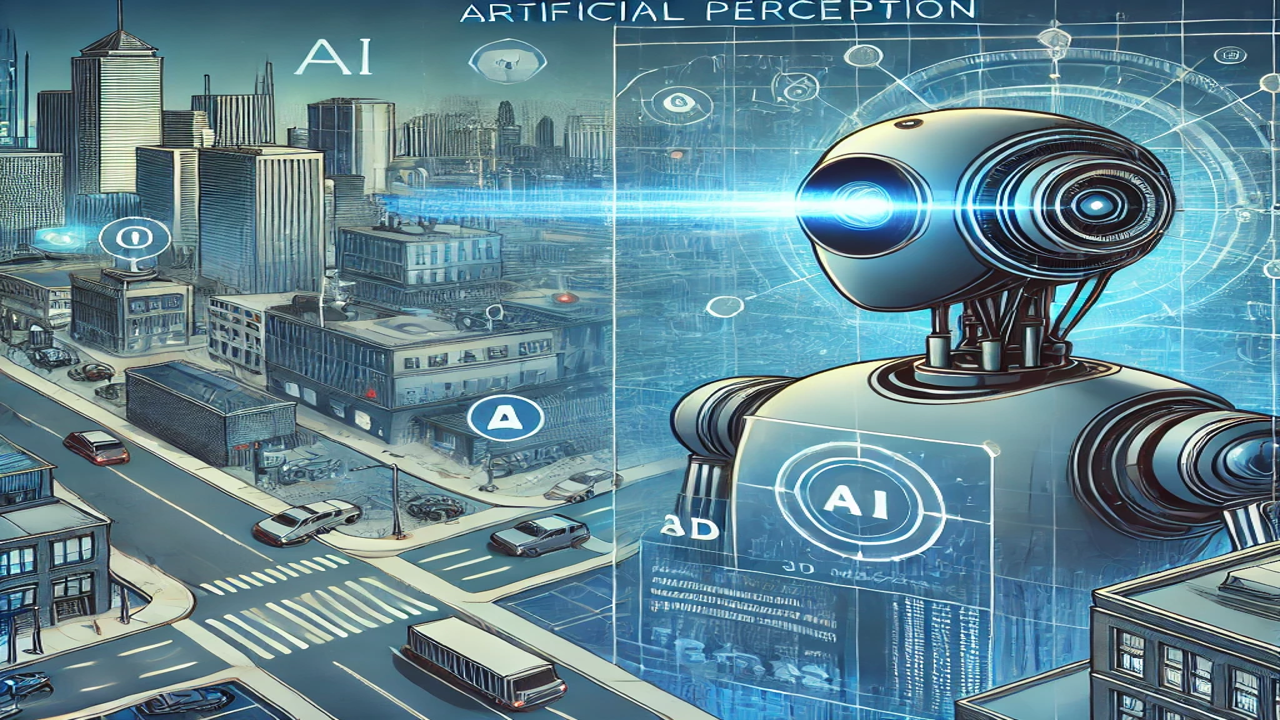

皆さんは、人工知覚という言葉を聞いたことはありますか?

人工知能ならあるけど… 知覚ってことは感覚、五感なんかのこと?

など、ピンとこない方も多いのではないでしょうか。

人工知覚(≒SLAM=Simultaneous Localization and Mapping)は、自律ロボットや自動運転車の技術革新において不可欠な要素で、これらの技術は、ロボットが環境を理解し、正確に移動するために必要なんです。

本記事では、人工知覚とSLAMの基本概念から具体的な応用事例、最新技術動向までを詳細に解説します。

人工知覚とは?基本的な事項について解説

センサー技術

人工知覚は、ざっくりといえばセンサーを通じてロボットが環境を認識する力のことです。

主要なセンサーとしてカメラ、LiDAR(Light Detection and Ranging)、レーダーがあります。

これらは言うなればロボットの「目」であり、そんな「目」役割を果たすものでもいくつも種類があるようです。

カメラ

カメラは視覚情報を取得するための基本的なツールで、RGBカメラや深度カメラを使って、画像データや3D情報を取得します。例えば、RGBカメラは色と形状を、深度カメラは距離情報を提供します。

LIDAR

LIDAR(ライダー)はレーザー光を使用して距離を測定し、3Dマップを作成します。高精度の点群データを生成するため、障害物の検出や詳細な環境マッピングに適しています。LiDARは特に自動運転車で重要な役割を果たしています。

レーダー

レーダーは電磁波を使用して物体の位置や速度を検出します。雨や霧などの悪天候条件でも安定して動作するため、車両の衝突回避システムに広く利用されています。

ロボットにとっての目(視覚)といっても、たくさんの種類があるんだな!

このほかにも、聴覚、触覚、嗅覚、味覚に相当する様々なセンサーがあるよ!

(今回は長くなるので割愛)

データ処理の基本

センサーから取得したデータは、アルゴリズムを通じて処理され、ロボットが環境を理解します。

例えば、カメラからの画像データは、コンピュータビジョンアルゴリズムを使用して物体認識やトラッキングが行われます。LiDARからの点群データは、3Dマッピングや位置推定に利用されます。

近頃の自動運転などの最新技術に至っては、これらの処理はリアルタイムで行われることが求められます。

SLAMとは?基本的な事項について解説

SLAMの基本原理

SLAM(Simultaneous Localization and Mapping)とは、ロボットが未知の環境で自己位置を推定しながら同時に地図を作成する技術です。SLAMの主要なステップは以下の通りです。

- センサーデータの取得: ロボットがセンサーを用いて環境データを収集します。

- 特徴点の抽出: データから環境の特徴点を抽出し、それを記録します。

- 自己位置推定: 現在の特徴点と以前の特徴点を比較し、ロボットの移動量を計算します。

- 地図作成: 位置推定結果を基に、環境の地図を更新します。

これらがリアルタイムに行われていくことで、高い精度での現在位置の推定ができるということです。

SLAMは、広い意味での「人工知覚」の一部であるといえるでしょう。

この「リアルタイム」というのが最も重要で、その実現には高いセンサ精度と高い計算処理能力(速度)が求められたんだ。近年の技術革新が両輪となって影響して、発展してきた分野なんだね。

SLAMの主要技術比較

Visual SLAM

カメラを使用したSLAM技術で、画像データから特徴点を抽出し、位置推定と地図作成を行います。コストが低い反面、光条件に依存するという課題があります。

iPhoneにもカメラを使用した距離測定アプリがあるけど、光の強かったりするとうまく測れないよね。

LiDAR SLAM

LiDAR(レーザー光)を使用したSLAM技術で、高精度な距離データを利用して地図を作成します。精度が高い一方で、センサーのコストが高く、重量もあるためプラットフォームに制約が生じます。

工事現場などでは、基礎の水平確認には以前から使われてきたよ。

最近では工場内をLIDARで3Dマッピングして、VR空間での設備の搬入/搬出なんかのシミュレーションもできるようになっているんだ!

最新技術の動向

センサーフュージョンの実例

センサーフュージョンは、複数のセンサーからのデータを統合し、各センサーの弱点を補完し合う技術です。これにより、全体の精度が向上します。例えば、自動運転車ではカメラ、LiDAR、レーダーのデータを統合して、より正確な環境認識を実現しています。

- 事例: 自動運転車は、カメラで道路標識や車線を認識し、LiDARで周囲の障害物を検出し、レーダーで他車の速度を測定します。これらのデータを統合することで、安全で効率的な運転が可能となります。

応用例の紹介

ドローン

ドローンはSLAM技術を用いて自律飛行しながら地図を作成します。農業では農作物の監視、災害救助では被災地の状況把握、インフラ点検では橋梁やビルの検査に利用されています。

ドローンのように3次元的に動く必要があるロボットは、SLAM技術が不可欠だね。

ロボット掃除機

ロボット掃除機はSLAM技術を用いて部屋の地図を作成し、効率的な清掃ルートを計画します。これにより、部屋全体を効果的に清掃できます。

やはりGAFAが強い

SLAMと人工知覚の分野では、日々新しい研究が進展しています。

例えば、GoogleのCartographerはGoogleが開発したオープンソースのライブラリで、リアルタイムの同時位置特定と地図作成(SLAM)を2Dおよび3D環境で実現するためのツールです。この技術はロボット、自動運転車、拡張現実(AR)などのアプリケーションで高精度な地図作成を可能にします。

LiDARやIMU(慣性測定ユニット)などのセンサーデータを統合し、周囲の環境の詳細な地図を構築すると同時に、ロボットの位置をリアルタイムで特定します。その特徴の一つは、ループクローズ(再訪したエリアの整合性を保つ技術)を効率的に処理できることです。これにより、長時間かつ複雑な環境での連続運用が可能になります。

このライブラリは、姿勢グラフの最適化やスキャンマッチングなどの高度なアルゴリズムを使用して高い精度とリアルタイムのパフォーマンスを実現しています。これにより、自律ロボットや自動運転車などのアプリケーションで高い精度が求められる場合に非常に有効です。

TechExplorist: What is LiDAR and How Does It Work

また、AppleのARKitやGoogleのARCoreは、スマートフォンでのSLAM技術を提供し、拡張現実(AR)アプリの開発を支援しています。

ARCore とサポートされている開発環境の概要 | Google for Developers

プラットフォームを作ることのビジネス上での強力さはすでに周知のとおりですが、この分野でもやはりGAFAといわれる企業は頭一つぬけていますね。

課題と解決策

技術的課題

SLAMと人工知覚には、技術的な課題がいくつか存在します。例えば、センサーデータのノイズや誤差、計算コストの高さなどです。これらの課題を解決するためには、より高度なアルゴリズムの開発や、センサー技術の進化が必要です。

未来の技術開発

現在、多くの研究者がSLAMと人工知覚の技術的課題に取り組んでいます。例えば、ディープラーニングを用いたセンサーデータのノイズ除去や、分散コンピューティングを用いた計算コストの削減などが研究されています。これらの技術が進展することで、より高精度で効率的なSLAMシステムが実現されるでしょう。

まとめ

人工知覚とSLAM技術は、自律ロボットの実現に向けて不可欠な要素です。これらの技術が進化することで、より高度な自律ロボットや自動運転車が実現し、私たちの生活に大きな影響を与えるでしょう。今後も、これらの技術の発展に注目していくことが重要です。

参考文献とリンク

Google ARCoreの動画はすごくおもしろかった!こんな技術が実世界に生かされているんだね。

コメント